Pues sí, hoy voy a hablar de evolución. Pero no de la evolución biológica (quizá en otro momento) ni siquiera de la evolución de los pokémon... Voy a hablar de una evolución más entretenida: la de las funciones de onda.

jueves, 26 de febrero de 2015

lunes, 23 de febrero de 2015

Mi punto débil

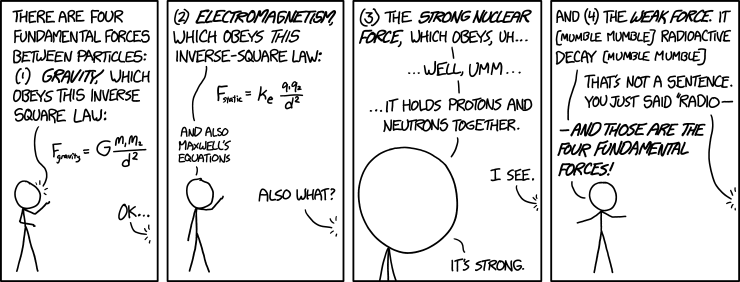

En la física actual, todas las interacciones entre partículas se describen en términos de cuatro fuerzas fundamentales: electromagnetismo, fuerte, débil y gravedad. La débil puede parecer el patito feo del grupo, pero conociéndola un poco mejor, con los fascinantes fenómenos que se producen, verás cómo es todo un cisne.

|

| xkcd explica magistralmente la fuerza débil (última viñeta). |

jueves, 19 de febrero de 2015

De radares y márgenes de error

Hoy la dirección general de tráfico ha dado a conocer datos sobre la ubicación y funcionamiento de los temidos radares móviles. Uno de ellos ha sido la publicación de los márgenes de tolerancia de los radares. Basándose en este hecho, en algunos medios de comunicación (por ejemplo, lo he visto en el programa "Más vale tarde" de la Sexta) se han preguntado si el conocimiento de estos márgenes supondrá que los conductores se dedicarán a ir al límite superior permitido por la tolerancia.

lunes, 16 de febrero de 2015

Quarks de colorines

Murray Gell-Mann consiguió poner orden en el desconcierto que causaba la multitud de hadrones con la invención de tres partículas, los quarks, que constituirían todos los posibles mesones y bariones. Sin embargo, en un principio su idea no suscitó mucha adhesión, ya que proponía la existencia de unas partículas que no se habían visto nunca, y que además tenían carga eléctrica fraccionaria.

sábado, 14 de febrero de 2015

¿Por qué lo llaman amor...

Cuando estoy contigo me siento libre,

Soy yo mismo, sin ninguna atadura.

Pero cuando me separo de ti, ¡ay, cuando me separo!

La distancia es insoportable, cada femtómetro una tortura.

No sé estar sin ti. No puedo estar sin ti. No debo estar sin ti.

La soledad o tu compañía, no hay color.

Es todo tan extraño...

¿Por qué lo llaman amor

cuando quieren decir cromodinámica cuántica?

Para mi quark, con encanto

tu antiquark.

jueves, 12 de febrero de 2015

El zoo de las partículas

Ernest Rutherford, junto con sus asistentes Geiger y Marsden, descubrió que los átomos no eran entidades indivisibles, sino que están compuestos por un núcleo que acapara (casi) toda la masa con carga positiva, y por los electrones pululando a su alrededor. Los núcleos tienen carga \(Ze\) y masa \(\sim A m_p\), siendo \(Z\) y \(A\) números enteros y \(m_p\) la masa del núcleo más ligero, el de hidrógeno.

miércoles, 11 de febrero de 2015

Neutrinos, los maestros del escapismo

Cuando crees que me ves, cruzo la pared

hago chas y aparezco a tu lado,

quieres ir tras de mí, pobrecito de ti,

quieres ir tras de mí, pobrecito de ti,

no me puedes atrapar.

domingo, 8 de febrero de 2015

Una constante muy fina

Los sistemas de unidades son muy prácticos para determinados cálculos. Sin embargo, el valor numérico de las magnitudes dimensionales no es algo fundamental, ya que depende del sistema de unidades elegido. Por el contrario, las magnitudes adimensionales son iguales en todas las unidades posibles. Al igual que las constantes matemáticas como \(\pi\) o \(e\), las constantes físicas adimensionales son las que nos proporcionan información sobre el funcionamiento del universo. Pero guardan una diferencia respecto de las constantes matemáticas: no pueden ser calculadas, sino que debemos determinarlas experimentalmente.

viernes, 6 de febrero de 2015

Jugando en grupo: SU(3)

Después del éxito de crítica y público cosechado por Jugando en grupo: U(1) y por su continuación Jugando en grupo: SU(2) llega a las mejores pantallas la última entrega de la trilogía, Jugando en grupo: SU(3). Más matrices. Más dibujos. Más representaciones. Y por primera vez, en tres dimensiones.

jueves, 5 de febrero de 2015

Cien años de Hofstadter

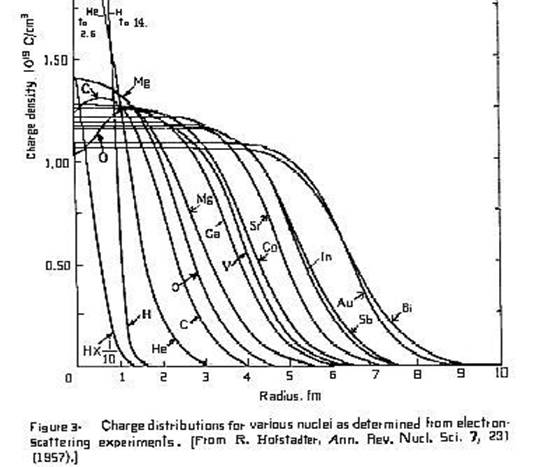

Hoy, 5 de febrero de 2015, se cumple el centenario del nacimiento de Robert Hofstadter. Aunque su nombre no sea uno de los más conocidos entre los físicos del siglo XX, su contribución fue esencial en el desarrollo del modelo nuclear.

Los primeros indicios de la existencia de un núcleo atómico se deben al famoso experimento de Rutherford, llevado a cabo por Geiger y Marsden. Consistía en bombardear una lámina metálica con partículas alfa (núcleos de helio-4). El hecho de que algunas de las partículas sufrieran grandes ángulos de dispersión indicaba que estaban interaccionando con una distribución de carga positiva concentrada en una región muy pequeña del átomo.

Sin embargo, las partículas alfa no son los proyectiles ideales para sondear el interior del núcleo. En primer lugar, con la energía a la que se podían acelerar las partículas alfa, su longitud de onda de de Broglie era muy superior al tamaño del núcleo, por lo que no se podía entrar en su interior. Además, la interacción entre la partícula alfa y el núcleo se produce mediante la fuerza fuerte, cuyo mecanismo no se conocía, así que no se podían interpretar teóricamente los resultados de los experimentos de dispersión.

Robert Hofstadter solucionó ambos inconvenientes empleando electrones como proyectiles. Al ser mucho más ligeros que las partículas alfa, se necesita menos energía para acelerarlos a la misma velocidad (y realizó el experimento 40 años después que Rutherford, con lo cual los medios experimentales eran más avanzados). Y como los electrones solo pueden interaccionar electromagnéticamente con los núcleos, los resultados hablaban por sí solos.

En un proceso de dispersión, la probabilidad de transición entre el estado inicial y el final esta dado por la regla de oro de Fermi:\[P\propto|\langle \psi_f |H_{em} |\psi_i\rangle|^2=|H_{if}|^2\]en donde \(H_{em}\) es el hamiltoniano correspondiente al electromagnetismo, que es proporcional a las densidad de carga \(\rho\). Las partículas antes y después de la dispersión se suponen libres, por lo que su función de ondas será una onda plana. Así pues, la amplitud de probabilidad de transición resulta: \[H_{if}\propto \int e^{i(\vec{k}-\vec{k}')\cdot\vec{r}} \rho(r) dr\] Esto no es más que la transformada de Fourier de la densidad de carga. Utilizando la transformada discreta, y suponiendo que el núcleo tiene simetría esférica (aunque normalmente esto no es cierto, puede ser una buena aproximación), se puede reconstruir la distribución de carga.

Hofstadter realizó el experimento con diversos materiales, empezando con el oro. Lo que encontró es que en el interior de los núcleos, la densidad de carga se mantiene constante hasta llegar a una distancia \(R\), que es el radio del núcleo. En el entorno del borde del núcleo, la densidad de carga empieza a disminuir rápidamente. Esta zona, con una anchura \(a\), se conoce como superficie. La densidad, una vez fuera de la superficie, tiene asintóticamente hacia cero, aunque no hay un límite definido del núcleo.

Comparando diferentes elementos, Hofstadter encontró que la anchura de la superficie es independiente del núcleo, y mide 0.5 fm [el fm es un femtómetro, es decir, 10-15 m. Hofstadter rebautizó esta unidad como "fermi" en honor del gran físico italiano, y ese nombre es muy frecuente en el ámbito de la física nuclear]. Por otra parte, el volumen de los núcleos era directamente proporcional al número de nucleones. Este resultado fue bastante sorprendente: al aumentar el número de nucleones, la atracción entre estos debería aumentar, con el efecto de contraer el núcleo. Sin embargo, los nucleones parecían incompresibles (que no incomprensibles): la razón es que la fuerza fuerte tiene muy poco alcance, y cada nucleón solo siente a sus vecinos más próximos, del mismo modo que en un líquido las moléculas solo sienten a sus vecinas. Esto dio lugar a que Gamow y Weiszäcker elaboraran el modelo de la gota líquida del núcleo, que permite computar su masa, y en consecuencia predecir qué tipo de reacción radiactiva puede sufrir.

Hofstadter recibió el premio Nobel en 1961 por estos experimentos. Aunque quizá el reconocimiento por el que es más recordado es porque los guionistas de la serie The big bang theory bautizaron a uno de sus protagonistas, Leonard Hofstadter, en su honor.

martes, 3 de febrero de 2015

Materia vs Antimateria

"Había mucho más escondido en la ecuación de Dirac que lo que su autor había esperado cuando la escribió en 1928. El propio Dirac remarcó en una de sus conferencias que la ecuación era más inteligente que su autor. Sin embargo, debería añadirse que fue Dirac el que encontró la mayoría de las implicaciones adicionales" - V. Weisskopf

En nuestros intentos por obtener una ecuación de ondas para una partícula relativista, nos habíamos topado con que las ecuaciones se empeñaban en darnos soluciones con energía negativa en pie de igualdad con las de energía positiva, lo cual parecía indicar la inestabilidad de toda la materia. La existencia de estas soluciones en la ecuación de Klein-Gordon era de esperar, porque habíamos empezado elevando al cuadrado la energía, pero no en la ecuación de Dirac. Parece que hay más historia detrás de este problema.

Dirac y el mar

La ecuación de Dirac nos había proporcionado más cosas además de las soluciones conflictivas. Nos había obligado a usar como funciones de onda biespinores, vectores de cuatro componentes, que a su vez habíamos dividido en dos espinores. Cada una de las componentes del espinor las habíamos asociado a las proyecciones del espín según el eje z. Por lo tanto, la ecuación de Dirac nos estaba describiendo partículas con espín 1/2, fermiones. Por lo tanto, están sujetas al principio de exclusión de Pauli.La idea de Dirac fue suponer que todos los niveles de energía negativa estaban ocupados, formando el "mar de Dirac". Por lo tanto, un electrón no podía pasar de los niveles de energía positiva a los de energía negativa. Notad que eso supone que el estado de vacío tiene infinita energía y carga negativas. Sin embargo, esto no supondría un problema, ya que son las diferencias de energía y carga las que tienen relevancia física.

¿Podemos observar los estados de energía negativa? Pongámonos en el caso del vacío, en el que todos los niveles de energía negativa (\(E \leq -mc^2\)) están completos, y todos los de energía positiva (\(E \geq mc^2\)) vacíos. Si añadimos una energía mayor que \(2mc^2\), podemos conseguir que uno de los electrones de energía negativa salte a niveles de energía positiva: por una parte nos queda un electrón, de los de toda la vida, con energía positiva \(mc^2\), y por otro lado, una vacante en el mar de Dirac, también con energía positiva. Si ahora aplicamos un campo eléctrico de izquierda a derecha, el electrón real se mueve de derecha a izquierda por tener carga negativa. Los electrones del mar de Dirac no pueden moverse porque los niveles adyacentes están ocupados, excepto si tienen a su lado la vacante, en cuyo caso se mueven también de derecha a izquierda. El resultado es que la vacante se va desplazando de izquierda a derecha, tal y como lo haría una carga positiva. Por lo tanto, la vacante, a la que llamaremos positrón y trataremos como una partícula elemental, tiene la misma masa y energía que un electrón, y carga y momento opuestos. Si el electrón coincide con el positrón, el estado de mínima energía es que baje de nuevo al mar de Dirac, por lo tanto aniquilando electrón y positrón. La diferencia de energía se liberará en forma de fotones.

|

| Fotografía de un electrón y un positrón generados en una lámina de plomo, realizada por Anderson |

Así pues, toda partícula de espín 1/2 tiene, cortesía de Dirac, una antipartícula que es su acérrima enemiga (sí, las partículas neutras como el neutrón o el neutrino también, y aunque no cambien su carga sí que cambian otros números cuánticos). Pero ha ocurrido algo curioso: hemos empezado con una ecuación para describir una única partícula y hemos concluído la necesidad de tratar con un número no solo arbitrario, sino también variable, de ellas. La forma de hacerlo es mediante teoría cuántica de campos, donde las partículas (y antipartículas) no son más que excitaciones de un campo, que se pueden crear y destruir de forma tan sencilla como los cuantos de energía en el oscilador armónico. La teoría cuántica de campos también permite explicar las antipartículas con otros espines, y eliminar los problemas con las soluciones de energía negativa en la ecuación de Klein-Gordon.

Haciendo balance

Uno de los grandes interrogantes a los que se enfrenta la física es por qué la materia predomina sobre la antimateria. Y sabemos que domina la materia porque no nos llegan grandes cantidades de rayos gamma correspondientes a la aniquilación de galaxias y antigalaxias.

Las leyes de la física las tratan por igual, así que la opción de que en el big bang solo se creara materia suena un tanto extraña. La otra opción es que haya algún proceso que favorezca la materia sobre la antimateria, la bariogénesis. Shakarov propuso las condiciones que deben cumplir las leyes físicas para permitir la bariogénesis: no conservación del número bariónico (número de partículas menos número de antipartículas), violación de la simetría CP (inversión de carga y reflexión especular), y procesos fuera de equilibrio. Es posible que el modelo estándar pueda explicar parte o toda la bariogénesis que ocurrió en los primeros momentos del universo.

Un caso intermedio es el de los semiconductores, que tienen su última banda completa, pero la siguiente está muy próxima. Tanto que las fluctuaciones térmicas son capaces de subir electrones desde la última banda completa hasta la primera vacía. El electrón que ha subido puede moverse al aplicarse un campo eléctrico. Mientras tanto, en la banda (casi)completa, los electrones pueden moverse a la vacante dejada por el electrón migrante. El movimiento del conjunto de electrones de la parte superior de la banda, con masa efectiva negativa, equivale al de una partícula con carga y masa efectiva positivas, y cuasimomento contrario: un hueco. Por lo tanto, en un semiconductor existen dos tipos de portadores de carga que contribuyen a la conducción eléctrica: electrones y huecos.

Hazme un hueco

Un fenómeno similar ocurre en los sólidos cristalinos. Estos presentan bandas de energía, en los que caben un número máximo de electrones cortesía del principio de exclusión de Pauli. Si una banda está completa, sus electrones (en promedio) no se mueven bajo el efecto de un campo eléctrico por no tener estados accesibles a los que ir: así pues, un conductor es un material que tiene capas a medio llenar, mientras que un aislante tiene todas sus bandas completas.Un caso intermedio es el de los semiconductores, que tienen su última banda completa, pero la siguiente está muy próxima. Tanto que las fluctuaciones térmicas son capaces de subir electrones desde la última banda completa hasta la primera vacía. El electrón que ha subido puede moverse al aplicarse un campo eléctrico. Mientras tanto, en la banda (casi)completa, los electrones pueden moverse a la vacante dejada por el electrón migrante. El movimiento del conjunto de electrones de la parte superior de la banda, con masa efectiva negativa, equivale al de una partícula con carga y masa efectiva positivas, y cuasimomento contrario: un hueco. Por lo tanto, en un semiconductor existen dos tipos de portadores de carga que contribuyen a la conducción eléctrica: electrones y huecos.

Para saber más...

Enrique F. Borja: Aprovechando que el pisuerga pasa por Valladolid, las partículas de Majorana., Pero papá, ¿por qué domina la materia?. Cuentos Cuánticos.

Pedro Gómez-Esteban: Esas maravillosas partículas: el positrón. El tamiz

Suscribirse a:

Entradas (Atom)